この記事のポイント

-

クローリングとは

-

クローリングとは、Web領域でプログラムを使うことによってWebページの情報収集する手法のことです。

-

クローリングするファイルの種類

-

クローラーが収集できるデータは基本的にテキストのみであり、デザインなど視覚的な情報の評価には対応していません。そのため、クローラーに情報を円滑に伝えるためには、テキストの情報を充実させる必要があります。代表的な例がHTMLファイルです。ほかにもPFPファイルや、JavaScriptで生成されているリンク、Flash内のリンク、PDFやWordファイルなどが対象になります。

-

クローリングをさせる方法

-

クローリングが行われていない場合は、制作側からのアクションでクローリングを求めることも可能です。Webサイト全体をクローリングさせたい場合、「XMLサイトマップ」をGoogle Search Consoleにインポートします。ページ単位でクローラーを呼び込むにはGoogle Search ConsoleのURL検査を利用します。

SEO対策について調べている方であれば「クローリング」というワードを耳にしたことがあるのではないでしょうか。検索エンジンを利用するユーザーにWebサイトを見てもらうためには、意識せずにはいられない存在です。一方で、SEO対策のなかでは優先度が低い部分でもあります。

この記事では、クローリングの概要や重要性、混同されやすい「スクレイピング」や具体的な対策方法まで、わかりやすく解説します。公開したWebサイトへのアクセスがないことにお悩みの方は、ぜひ参考にしてください。

SEOで順位が上がらない担当者様へ

実力のあるSEOコンサルタントが本物のSEO対策を実行します。

SEO会社に依頼しているが、一向に検索順位が上がらない・・・。

SEO対策をSEO会社に依頼していてこのようなお悩みはありませんか?SEO対策はSEOコンサルタントの力量によって効果が大きく変わるマーケティング手法です。弊社では価値の高いSEOコンサルティングをご提供するため、厳選した業界トップクラスの大手SEO会社出身で大規模サイト運用経験のあるトップコンサルタントが在籍しております。

SEO対策とは?SEO対策の効果と基本から改善方法【プロ監修】

SEO対策は、ウェブサイトの検索エンジン順位を向上させ、集客力を高めるための施策です。この記事では、SEOの基本概念や効果、具体的な改善方法について詳しく解説しています。

SEO対策とは?SEO対策の効果と基本から改善方法【プロ監修】

SEO対策は、ウェブサイトの検索エンジン順位を向上させ、集客力を高めるための施策です。この記事では、SEOの基本概念や効果、具体的な改善方法について詳しく解説しています。

目次

クローリングとはプログラムがWebサイトを巡回すること

まずは、クローリングの概要について解説します。

クローリングとは、Web領域でプログラムを使うことによってWebページの情報収集する手法のことです。泳法のひとつであるクロールのような這いつくばるイメージが由来となっています。新しいWebサイトを認識し、情報を取得するために使われる技術です。

クローリングを行うプログラムは「クローラー」、もしくは「スパイダー」と呼ばれます。クローラーが機能しているおかげで、検索エンジンにWebサイトの情報が送られ、ユーザーの検索意図に沿った検索結果が表示されるようになるのです。

以下では、クローラーについてのさらに詳しい情報や「クローラビリティ」という概念、同じような意味で使われる「スクレイピング」、クローリングするファイルの種類についてお話しします。

クローラーとは?検索エンジンにインデックスされる仕組みや巡回頻度を上げる方法解説

Webサイトを制作、公開しても検索結果に表示されないと検索エンジン経由の集客はできません。検索エンジンがWebサイトの情報を取得するために使用しているのがクローラーです。クローラーがサイトの情報をどのように取得しているのか、基本的なところから解説します。

クローラーとは?検索エンジンにインデックスされる仕組みや巡回頻度を上げる方法解説

Webサイトを制作、公開しても検索結果に表示されないと検索エンジン経由の集客はできません。検索エンジンがWebサイトの情報を取得するために使用しているのがクローラーです。クローラーがサイトの情報をどのように取得しているのか、基本的なところから解説します。

クローラーとクローラビリティについて

クローラーはクローリングを行うプログラムのことであり、自律的に稼働するため「ロボット」と表現されることもあります。WebサイトやWebページの情報を収集し、データベースに保管するのがクローラーの役割です。データベースへ情報を格納する作業は「インデックス」と呼ばれます。

クローラビリティとは、「そのWebサイトがクローラーにとってどれだけ巡回しやすいか」を示す概念です。クローラーは常にWebサイトの情報収集を行っていますが、すべてのWebサイトを巡回しているわけではありません。クローラーに優先的に発見してもらうためには、クローラビリティを高める必要があります。

<無料>資料ダウンロード

【サイト運営者必見】SEO対策成功事例集

実例から学ぶ、急成長を遂げたストーリーが見られる!

スクレイピングとの違い

スクレイピングとは「削り取る」という意味の英単語であり、Webの世界ではHTMLテキストから必要な情報のみを抽出することを意味します。

クローリングで取得する情報は、すべてが重要というわけではありません。特に用途がない無駄な情報も含まれています。スクレイピングはクローリングで取得したそうした情報から不要な情報を削り取り、重要な情報を取得する技術です。ページタイトルや見出しなどが、スクレイピングで取得する情報の代表例として挙げられます。

Webサイトからの情報抽出は「クローリングによる取得情報をスクレイピングする」という大まかな流れで行われます。そのため、クローリングとスクレイピングは一般的にひとつのセットとして考えられている技術です。

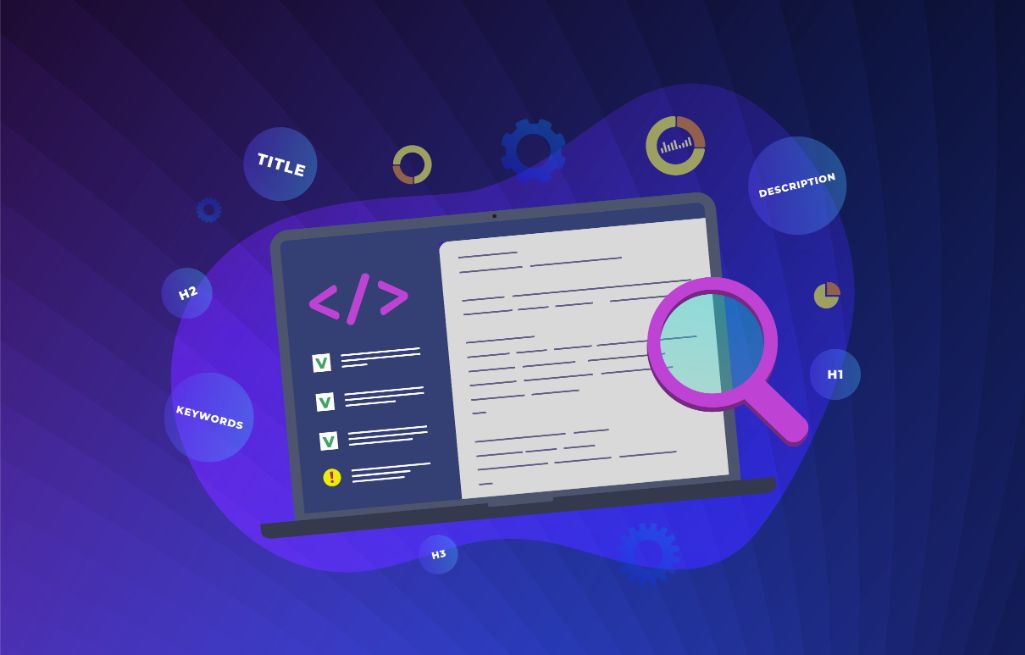

クローリングするファイルの種類

クローリングは多くのファイルを対象として行われます。代表的な例が、HTMLファイルです。クローラーはほかにも以下のようなファイルを読み込みます。

- PFPファイル

- JavaScriptで生成されているリンク

- Flash内のリンク

- PDFファイル

- Word、PowerPointのファイル

これらのファイルに共通しているのは、「テキストデータである」という点です。クローラーが収集できるデータは基本的にテキストのみであり、デザインなど視覚的な情報の評価には対応していません。そのため、クローラーに情報を円滑に伝えるためには、テキストの情報を充実させる必要があります。

クローリングの重要性

Web制作においてクローリングが重要視される最大の理由は、「クローリングの有無が検索結果に影響を与える」からです。

簡単に言えば、クローリングが行われていないWebサイトは、検索エンジンの検索結果に表示されません。これは、Webサイトの情報が検索エンジンのデータベースに登録されていないためです。特に新しく開設したWebサイトの場合、ユーザーのアクセスを増やすためにはまずクローラーに巡回してもらう必要があります。

Webサイトを巡回するクローラーの種類

クローリングを行うのはクローラーというロボットです。クローラーにはいくつかの種類があります。以下では、代表的なクローラーである「Googlebot」とそれ以外のクローラーについて解説します。

Googlebot

「Googlebot」はGoogleが保有しているクローラーです。収集したWebサイトのデータはGoogleのデータベースに格納されます。なお、GoogleはGooglebotのほかにも画像用の「Googlebot-Image」、動画用の「Googlebot-Video」、ニュース用の「Googlebot-News」を使い分けています。

詳細な情報は「Google検索セントラル」の「Googleクローラの概要(ユーザーエージェント)」で確認可能です。

Googleの検索エンジンは、GoogleのほかYahoo!でも使用されています。したがって、Yahoo!で使用されているクローラーもGooglebotということになります。

日本の検索エンジンシェアはGoogleとYahoo!で96%を占めているため、クローラビリティを高める取り組みは必然的にGooglebotを意識して行うことになるでしょう。

その他のクローラー

マイクロソフト社の検索エンジンBingの「Bingbot」や、中国の検索エンジン百度の「Baiduspider」などのクローラーがあります。いずれのクローラーもGooglebotと同じようにWebサイトの情報を、各検索エンジンのデータベースに格納する役割を担っています。

また、WebサイトやWebサービスが保有するクローラーもあるようです。詳細は公表されていませんが、求人情報サービスの「Indeed」がクローラーを保有しており、掲載する求人案件の選定に活用していると言われています。

検索エンジンとは?仕組み・種類・アルゴリズムをわかりやすく解説

検索エンジンは、ユーザーが入力したキーワードに基づき、関連するウェブページを検索結果として表示するシステムです。その仕組みや種類、アルゴリズムについて詳しく解説しています。

検索エンジンとは?仕組み・種類・アルゴリズムをわかりやすく解説

検索エンジンは、ユーザーが入力したキーワードに基づき、関連するウェブページを検索結果として表示するシステムです。その仕組みや種類、アルゴリズムについて詳しく解説しています。

Webサイトにおけるクローリングの2つの確認方法

上述したとおり、クローリングが行われていないサイトは検索結果に表示されません。作成したWebサイトがクローリングされているか確認する方法はあるのでしょうか。以下では、代表的な2つの方法について案内します。

1.Google Search Consoleで確認する

「Google Search Console」ではWebサイトのクローリング状況を確認可能です。

「インデックス」の「カバレッジ」で表示されるURLは、クローラーによってすでにインデックスされていることを意味します。また、「URL検査」では、任意のページのクローリング状況を確認可能です。

Webサイト全体のクローリング状況を知りたい場合は「クロールの統計情報」を確認します。クロールリクエストの合計数、クローラーが取得したデータの合計サイズ、データ取得にかかる時間などを確認できます。

特に重要なのがデータのダウンロード時間です。ダウンロード時間が長いと、クローラーが巡回を控えるケースがあります。

Googleサーチコンソールとは?使い方と登録方法や設定を解説

Webサイトの集客状況を分析する際にGoogleアナリティクスと同じくらい役立つのがGoogleサーチコンソールです。サーチコンソールへの登録方法やGoogleアナリティクスとの連携方法について、わかりやすく解説します。

Googleサーチコンソールとは?使い方と登録方法や設定を解説

Webサイトの集客状況を分析する際にGoogleアナリティクスと同じくらい役立つのがGoogleサーチコンソールです。サーチコンソールへの登録方法やGoogleアナリティクスとの連携方法について、わかりやすく解説します。

2.Webサーバーの生ログを確認する

生ログを見ることでも、クローリングの状況を確認できます。生ログとは、Webサーバー上に記録されている無加工のアクセスログのこと。具体的には、アクセス時間、アクセス地域、検索キーワードなどが生ログとして蓄積されます。

Google Search Consoleと比較すると、より詳細な情報を確認できる点が生ログの特徴です。どのクローラーがWebサイトに訪問しているのかがわかるほか、ページ・ディレクトリ・テンプレートといった単位でのクローリング状況も把握できます。

Google Search Consoleの利用よりも少し上級者向けではありますが、より高度なSEO対策を行いたい場合はおすすめの方法です。

クローリングをさせるための2つの方法

Webサイトのクローリングが行われていない場合は、制作側からのアクションでクローリングを求めることも可能です。以下では、Webサイト全体をクローリングさせる方法と、ページ単位でクローリングさせる方法をご紹介します。

Webサイト全体をクローリングさせる

Webサイト全体をクローリングさせたい場合、「XMLサイトマップ」をGoogle Search Consoleにインポートします。

XMLサイトマップとは、「情報が更新されたページのURL」「更新の時期」「更新頻度」「クローリングの優先度」といった情報が記載されたファイルのことです。XMLサイトマップがあることで、クローラーはWebサイト内を効率的に巡回できるようになります。

XMLサイトマップは無料のエディターでも作成可能です。WordPressを利用している場合はXMLサイトマップを簡単に作れるプラグインが用意されています。生成されるファイル名は「sitemap.xml」です。

Webサイト全体をクローリングさせたい場合は、Google Search Consoleの「クロール」から「サイトマップ」を選択してください。右上の「サイトマップの追加/テスト」というボタンをクリックし、作成した「sitemap.xml」をインポートしましょう。

Search Consoleでサイトマップを送信する方法

Google Search Consoleでサイトマップを送信する方法を解説しています。サイトマップの重要性やSEO効果、作成手順、送信方法、注意点について詳しく説明しています。

Search Consoleでサイトマップを送信する方法

Google Search Consoleでサイトマップを送信する方法を解説しています。サイトマップの重要性やSEO効果、作成手順、送信方法、注意点について詳しく説明しています。

URL検査を行う

Google Search Consoleの「URL検査」を利用すると、ページ単位でクローラーを呼び込めます。左メニューの「URL検査」をクリックし、クローリングさせたいページのURLを上部に入力しましょう。データの取得が終わった後、「インデックス登録をリクエスト」をクリックするとクローラーが該当ページをインデックスします。

なお、以前はページ単位のクローラー誘導のために「Fetch as Google」という機能を利用していましたが、2019年3月28日以降はURL検査に置き換わっています。Fetch as Googleの機能が引き継がれているほか、改善・改良が行われていますので現在はURL検査を利用してください。

SEO効果を高めるクローリングの対策方法4つ

Webサイトを検索結果に表示させるためには、まずクローリングしてもらわなければなりません。また、検索上位の表示を狙っている場合は、SEO効果を高めるためのクローリング対策を行う必要があります。

以下では、SEO効果の向上が期待できる具体的なクローリング対策を4つご紹介します。

1.クローラーを呼びクローリングを始めさせる

まず、クローラーを呼び込み、クローリングを開始させる必要があります。新しいWebサイトやコンテンツを作成した場合、機会損失を防ぐためになるべく早くクローラーを呼び込むことが好ましいでしょう。

クローラーの呼び込みには、上述したようにサイトマップのインポート、URL検査の2つ方法があります。ページ単位でクローラーを呼びたい場合はURL検査でも問題ありませんが、新しいWebサイトの解説時など複数のページがある場合は非効率です。

サイトマップはクローラーにとってWebサイト全体を、クローリングするための地図となります。そのため、新サイト開設時はサイトマップのインポートが第一選択となります。

2.クローリングを促す

SEO効果を高める上では、円滑なクローリングを促進することも重要です。「クローリングしやすいサイト」と認識されれば、Googleに「有益なサイト」として認識してもらいやすくなります。インデックスのスピードも速くなるため、SEO上も好影響が期待できるでしょう。

以下では、クローリングを促進する方法を4つ紹介します。

sitemap.xmlを作成する

サイトマップの作成はクローラーを呼び込むために必要な工程であり、クローリングの促進を期待するうえでも重要です。上述したとおり、サイトマップはクローラーがWebサイト内を巡回するための地図として機能します。サイトマップがあることによって、クローラーの巡回は大幅に効率的になるのです。

この点を踏まえると、Webサイトの立ち上げ時にサイトマップをインポートするだけでは十分とは言えません。新しいページやコンテンツの追加、リニューアルを行った際は、その都度サイトマップを更新するのが好ましいでしょう。

目立った更新がない場合もWebサイトは少しずつ変化していくため、定期的にサイトマップを作成し、インポートすることをおすすめします。

RSSフィードを作成する

RSSフィードの作成もクローリングの促進効果を期待できる方法です。RSSはWebサイトの更新状況をユーザーに通知するためのマークアップ言語です。主にブログやオンラインマガジンで使用されています。

WebサイトにRSSフィードを設置しておくと、クローラーは更新情報を取得しやすくなります。

RSSを利用して、新規ページの設置を検索エンジンに伝えることも可能です。Google Search Consoleの「サイトマップ」から「新しいサイトマップの追加」をクリックしてください。その後、ボックス内に「feed」と入力するとRSSフィードの作成・送信ができます。

PubSubHubbub

「PubSubHubbub」は検索エンジンにWebサイトの更新を知らせる仕組みのひとつです。「Publisher」「Subscriber」「Hub」「hubble-bubble」の組み合わせが名前の由来になっており、それぞれ以下のような意味を持っています。

- Publisher:Webサイトの更新情報を配信するもの

- Subscriber:Webサイトの更新情報を受信するもの

- Hub:PublisherとSubscriberの仲介者

- hubble-bubble:ぶくぶくしている様子

PublisherはWebサイトそのもの、Susbriberはクローラーとして置き換えても問題ありません。通常はクローラーの定期的な巡回を待つしかありませんが、PubSubHubbubを利用すると更新状況をリアルタイムでクローラーに伝えられます。

PubSubHubbubを実施したい場合、通常はPHPを利用することになります。WordPressのWebサイトであれば「WebSub/PubSubHubbub」というプラグインで導入できるため簡単です。

PINGを送信する

PING送信とは、Webサイトの更新を「pingサーバー」へ通知する仕組みのことです。pingサーバーとはWebサイトの更新情報が集積されるサーバーのこと。更新情報を受け取ったpingサーバーは、連携しているサイトその更新情報を配信します。

SEOでの効果は薄いと考えられていますが、クローラーはpingサーバーも巡回しているためpingを送信しておくとインデックスが速くなります。大きな効果はありませんが、特にデメリットもないため、送信しておくのがおすすめです。

WordPressでは、「設定」の「投稿設定」をクリックすると「更新情報サービス」が表示されます。こちらに、通知先として希望するpingサーバーのアドレスを入力することでpingを送信できます。

3.クローリングをさせない

ここまでWebサイトや特定のページをクローリングさせる方法について解説してきました。一方で、SEOのためにあえてクローリングを抑制することもあります。以下では「クローリングさせない」という判断の理由と、方法についてお話しします。

インデックスがいらない場合はクローリングさせない

SEO効果が見込めない、もしくはWebサイトの評価を下げてしまう可能性があるページに関しては、最初からクローリングをさせないように制御しておくことが好ましいでしょう。例として「情報がないページ」があげられます。

ブログの場合、未来の日付など。まだ情報が投稿されていない日のページが設けられていることも少なくありません。こうした「情報がないページ」をクローラーが見つけた場合、「価値のないWebサイト」として認識される可能性があります。

また、ECサイトや不動産物件サイトなどで利用できる検索機能にも注意が必要です。ユーザーが入力する条件によっては該当するものがない「情報がないページ」が検索結果として表示されることも考えられます。こうしたページが大量にインデックスされれば、Webサイトの評価が落ちてしまうのです。

クローリングを制御させる

Webサイト内に上述したような情報のないページがある場合、クローリングを制御する必要があります。具体的には以下のような方法で、特定ページへのクローラーの巡回を回避します。

- nofollow:特定のリンクへのクローラー巡回を回避するタグ

- meta robots nofollow:ページ内のすべてのリンクへのクローラー巡回を回避するタグ

- robots.txt:特定ページのクローリングを不許可にするファイル

- .htaccess:特定ディレクトリ内のファイルへのクローリングを禁止するファイル

- meta robots noindex:検索結果に表示させなくするタグ(クローリング・インデックスは行われる)

noindexとnofollowとは?違いや正しい書き方、確認方法

SEO対策で使用されるnoindexとnofollowの役割や違いについて解説しています。正しい記述方法や、設定を確認するための手順を紹介し、適切に活用することでSEO効果を最大化する方法を学べます。

noindexとnofollowとは?違いや正しい書き方、確認方法

SEO対策で使用されるnoindexとnofollowの役割や違いについて解説しています。正しい記述方法や、設定を確認するための手順を紹介し、適切に活用することでSEO効果を最大化する方法を学べます。

noindexとは?SEO対策を正しく理解してインデックスをコントロール

SEO対策の施策の1つとしてnoindexという言葉を聞いたことはありませんか?検索結果に特定のページを表示させないために設定するのがnoindexですが、なぜSEO対策になるのでしょうか?基本的なところから解説します。

noindexとは?SEO対策を正しく理解してインデックスをコントロール

SEO対策の施策の1つとしてnoindexという言葉を聞いたことはありませんか?検索結果に特定のページを表示させないために設定するのがnoindexですが、なぜSEO対策になるのでしょうか?基本的なところから解説します。

4.クローラビリティを向上させる

クローラビリティを意識し、クローラーが巡回しやすいWebサイト設計を行うとSEO上の評価が高まります。上述したサイトマップのインポートは基本ですが、Webサイトの設計を見直し、クローラビリティを向上させることも大切です。

例として、リンク切れページをなくすことが挙げられます。Webサイトを大きくしていくとページ管理が煩雑になり、リンク切れも増えていく傾向があります。目視でリンク切れを確認するのは時間がかかり、非効率的です。リンク切れの確認ツールなどが利用されています。

ページの表示速度もクローラビリティに影響します。評価を上げるためには、短時間で読み込めるページ作成が重要です。ファイルの圧縮、不要なソースコードの削除といった工夫で、ページの表示速度を上げられます。

クローリングのまとめ

クローリングが実施されていないWebサイトは検索エンジンに表示されません。つまり、ユーザーにアクセスしてもらうためのスタートラインにも立っていない状態と言えます。

どれだけ良質なコンテンツが充実しているWebサイトを構築しても、検索流入が期待できなければ意味がありません。まずはクローリング対策を行いましょう。

単にインデックスさせるだけではなく、クローラーが巡回しやすいWebサイト設計にするとSEO面での効果も上昇します。しかし、クローラビリティを向上させるためには細かな知識が必要となり、手間がかかるのも事実です。

ニューラルワークスでは、お客様のWebサイトへのクローリングを促す方法の案内やクローラビリティを高めるためのサポートを実施しております。WebサイトのGoogle評価を上げたいとお考えのお客様は、ぜひご相談ください。

<無料>資料ダウンロード

【成果に直結】Webサイトコンサルティング

Webのプロが成果の出るWebサイトへ改善いたします

SEOで順位が上がらない担当者様へ

実力のあるSEOコンサルタントが本物のSEO対策を実行します。

SEO会社に依頼しているが、一向に検索順位が上がらない・・・。

SEO対策をSEO会社に依頼していてこのようなお悩みはありませんか?SEO対策はSEOコンサルタントの力量によって効果が大きく変わるマーケティング手法です。弊社では価値の高いSEOコンサルティングをご提供するため、厳選した業界トップクラスの大手SEO会社出身で大規模サイト運用経験のあるトップコンサルタントが在籍しております。

クローリングのよくあるご質問

- クローリングとは?

-

クローリングとは、Web領域でプログラムを使うことによってWebページの情報収集する手法のことです。新しいWebサイトを認識し、情報を取得するために使われる技術です。

- スクレイピングとの違いは?

-

クローリングで取得する情報は、すべてが重要というわけではありません。特に用途がない無駄な情報も含まれています。スクレイピングはクローリングで取得したそうした情報から不要な情報を削り取り、重要な情報を取得する技術です。

- クローリングの重要性とは?

-

Web制作においてクローリングが重要視される最大の理由は、「クローリングの有無が検索結果に影響を与える」からです。特に新しく開設したWebサイトの場合、ユーザーのアクセスを増やすためにはまずクローラーに巡回してもらう必要があります。